本教程由社区贡献,不受 Open WebUI 团队支持。它仅作为如何根据您的特定用例自定义 Open WebUI 的演示。想要贡献?请查看贡献教程。

在 Iterm2 中使用您的 Open WebUI 模型

您可以在 Iterm2 AI 插件中使用您的 Open WebUI 模型。本指南将向您展示如何设置必要的配置。

为什么要使用 Iterm2 AI 插件?

每当您忘记命令或需要一个快速的 bash 脚本来完成重复性任务时,您可能已经在使用 AI 响应。为了简化此工作流程,Iterm2 AI 插件允许您向指定的 AI 提供商或您的 Open WebUI 发送请求。

为什么要连接到您的 Open WebUI 实例?

Open WebUI 提供了一种简单直接的方式,通过其API 端点与您的 LLM 进行交互。如果您在本地运行自己的 LLM,这尤其有利。此外,您可以利用所有已实现的功能、监控及其他能力。

先决条件

1. 下载 iTerm2 AI 插件

如果您尚未安装 iTerm2 AI 插件,则需要先从他们的页面下载。解压文件并将应用程序移动到您的应用程序文件夹中。

2. 生成您的 Open WebUI API 密钥

要通过您的 Open WebUI 实例进行身份验证,您需要生成一个 API 密钥。请遵循本指南中的说明来创建它。

配置

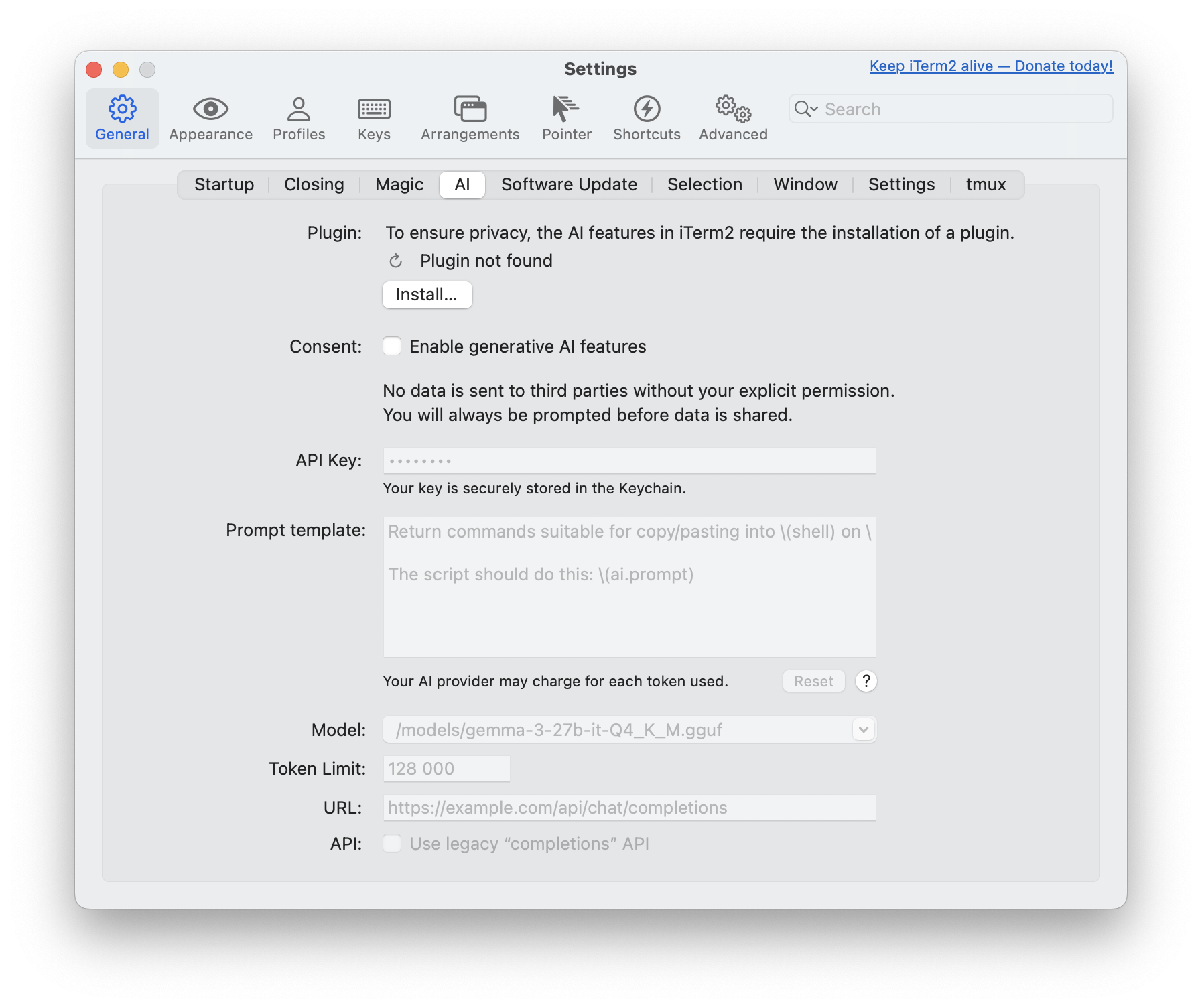

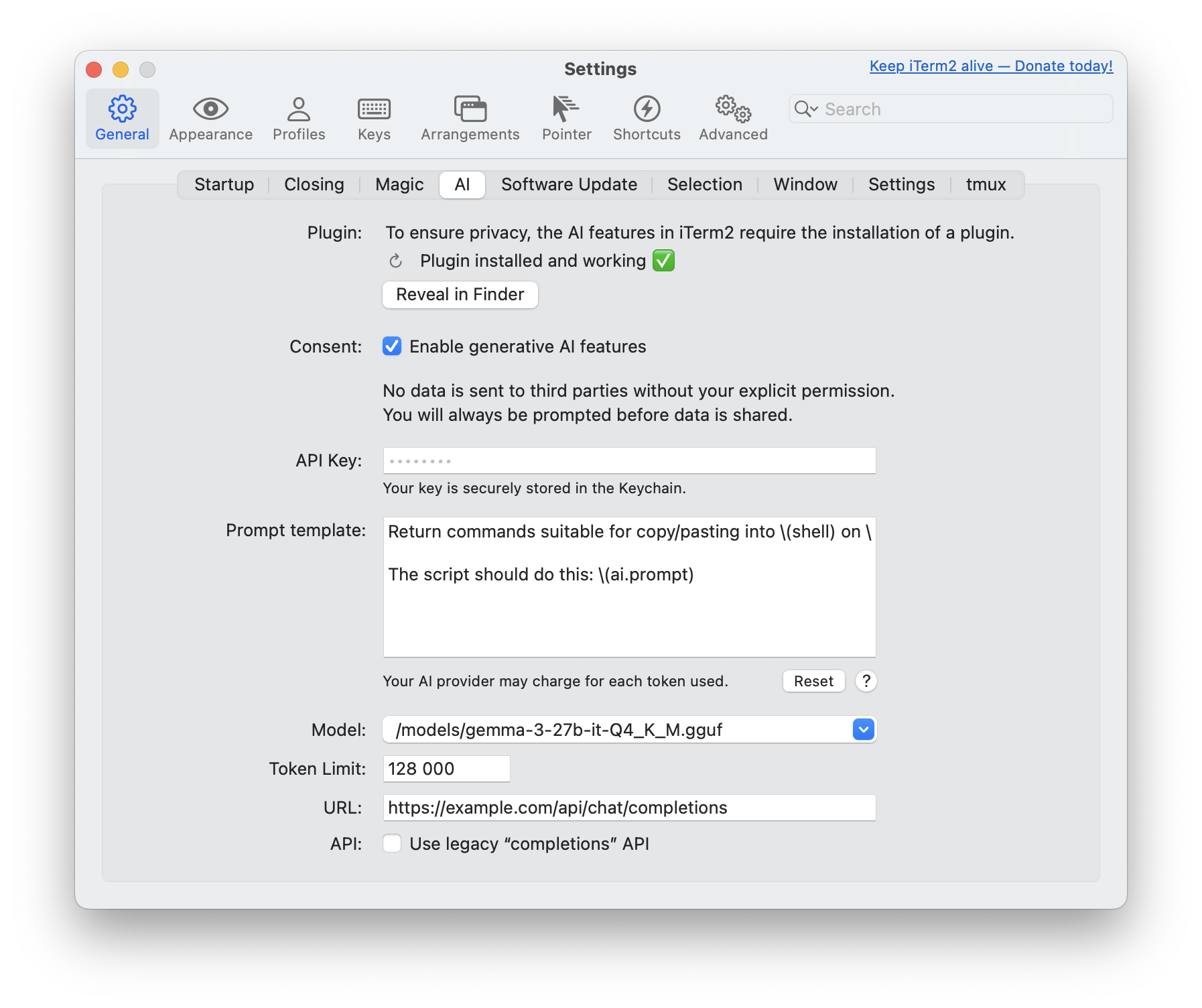

打开您的 iTerm2 终端,从 iTerm2 菜单导航到设置 (⌘,),然后选择AI 选项卡。

验证已安装的插件

iTerm2 AI 插件安装后,请验证插件部分是否显示插件已安装并正常工作 ✅。

同意生成式 AI 功能

在同意部分下,勾选启用生成式 AI 功能以表示同意。

设置 API 密钥

将您之前创建的 Open WebUI API 令牌输入到API 密钥字段中。

可选:自定义您的提示

如果您希望向您的 LLM 发送专用提示,请随意编辑提示模板。

原始提示示例

Return commands suitable for copy/pasting into \(shell) on \(uname). Do

NOT include commentary NOR Markdown triple-backtick code blocks as your

whole response will be copied into my terminal automatically.

The script should do this: \(ai.prompt)

您可以在原始文档中阅读有关 Iterm2 提示的更多信息。

选择您的 LLM

由于 iTerm2 AI 插件不会自动列出您的自定义模型,您需要手动添加您偏好的模型。在您的 Open WebUI 实例中,导航到管理面板 > 设置 > 模型,然后点击您偏好的 LLM。在用户给定的名称下方,您将找到需要输入到 iTerm2 中的实际模型名称(例如,名称:Gemma3 - 模型名称:/models/gemma3-27b-it-Q4_K_M.gguf)。

调整 Token 数量

在此处设置您偏好的 token 数量。通常,您的推理工具已经设置了限制。

调整 URL

这是关键一步:您需要将 iTerm2 AI 插件的请求指向您的 Open WebUI 实例。如果实例托管在某处,可以使用实际域名(例如 https://example.com/api/chat/completions),或者使用您的本地主机设置(例如 https://:8080/api/chat/completions)。您可以在API 端点指南中找到有关 URL 的更多信息。

旧版补全 API

Open WebUI 不需要此设置,但可以在原始指南中找到更多信息。

设置完成后,AI 部分将如下所示

使用方法

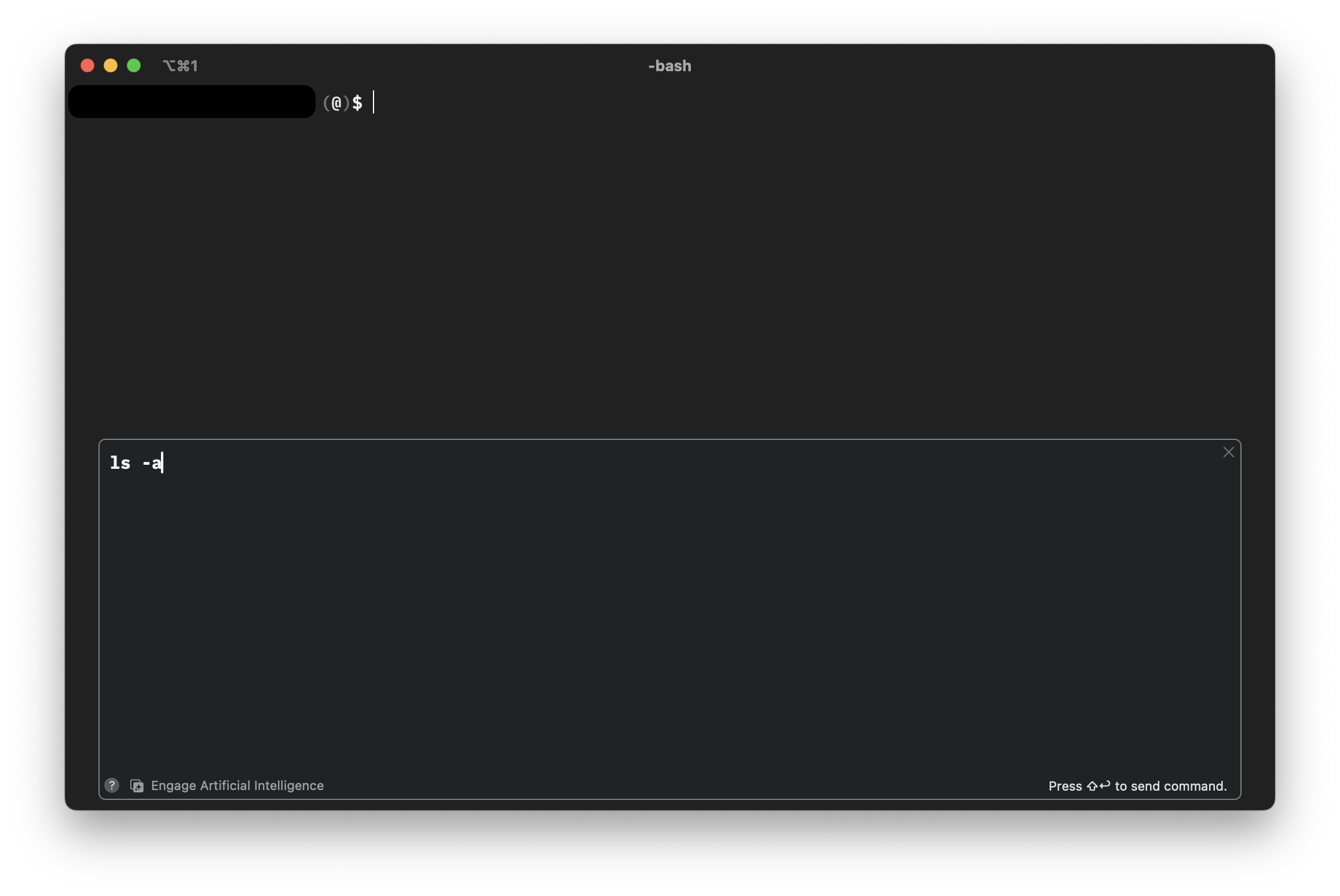

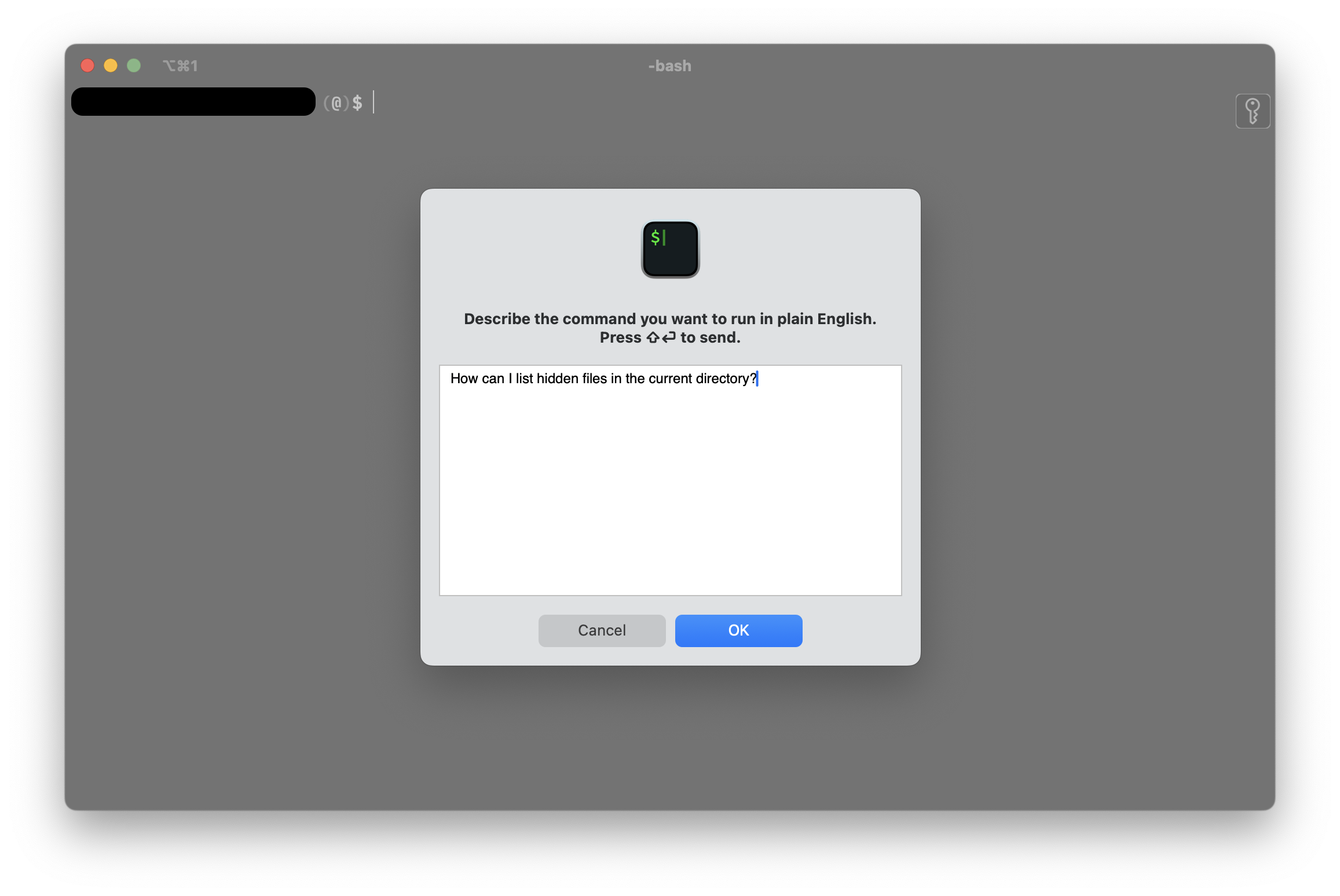

在您的终端会话中,按下 command + y (⌘y) 打开提示输入字段。编写您的提示,然后点击OK 按钮或使用 shift + enter (⇧⌤) 发送。

这将带您回到终端,并显示一个绑定到会话框架的额外窗口。您的查询结果将显示在此叠加层中。要将命令发送到您的终端,请将光标移动到目标行并使用 shift + enter (⇧⌤)。

响应可能不止一行。如果是这样,您可以使用方向键根据需要编辑命令。