本教程由社区贡献,不受 Open WebUI 团队支持。它仅作为演示,说明如何根据您的特定用例自定义 Open WebUI。想贡献?请查看贡献教程。

将 Continue.dev VSCode 扩展与 Open WebUI 集成

下载扩展

您可以在 Visual Studio Marketplace 上下载 VSCode 扩展,也可以在 VSCode 中直接通过 EXTENSION:MARKETPLACE 搜索 continue 进行下载。安装后,您可以通过 VSCode 侧边栏中的 continue 选项卡访问该应用程序。

VSCode 侧边栏图标

设置

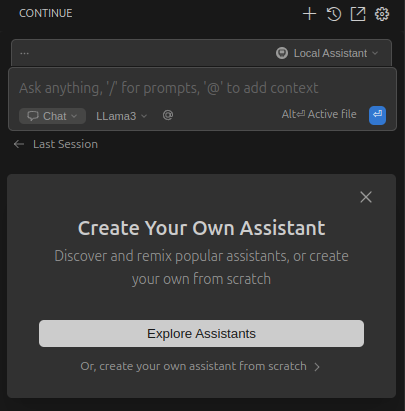

点击主聊天输入框右侧的助手选择器。然后将鼠标悬停在 Local Assistant 上,并点击设置图标 (⚙️)。这将会在您的编辑器中打开 config.yaml 文件。您可以在此处更改 Local Assistant 的设置。

目前,ollama 提供者不支持身份验证,因此我们无法将此提供者与 Open WebUI 一起使用。然而,Ollama 和 Open WebUI 都与 OpenAI API 规范兼容。有关该规范的更多信息,请阅读 Ollama 博客文章。我们仍然可以设置 continue.dev 使用 openai 提供者,这将允许我们使用 Open WebUI 的身份验证令牌。

配置示例

下面是 Llama3 作为模型并使用本地 Open WebUI 设置的配置示例。

name: Local Assistant

version: 1.0.0

schema: v1

models:

- name: LLama3

provider: openai

model: Meta-Llama-3-8B-Instruct-Q4_K_M.gguf

env:

useLegacyCompletionsEndpoint: false

apiBase: http://:3000/api

apiKey: YOUR_OPEN_WEBUI_API_KEY

roles:

- chat

- edit

context:

- provider: code

- provider: docs

- provider: diff

- provider: terminal

- provider: problems

- provider: folder

- provider: codebase

杂项配置设置

扩展程序正常工作需要这些值。更多信息请参阅官方配置指南。

name: Local Assistant

version: 1.0.0

schema: v1

上下文部分为模型提供额外信息。更多信息请参阅官方配置指南和上下文提供者指南。

context:

- provider: code

- provider: docs

- provider: diff

- provider: terminal

- provider: problems

- provider: folder

- provider: codebase

模型

模型部分用于指定您要添加的所有模型。更多信息请参阅官方模型指南。

models:

- ...

名称

设置您要使用的模型的名称。这将在扩展程序的聊天输入框中显示。

name: LLama3

提供者

指定用于与 API 通信的方法,在本例中是 Open WebUI 提供的 OpenAI API 端点。

provider: openai

模型

这是您在 Open WebUI 中模型的实际名称。导航到 Admin Panel > Settings > Models,然后点击您偏好的大型语言模型(LLM)。在用户给定的名称下方,您会找到实际的模型名称。

model: Meta-Llama-3-8B-Instruct-Q4_K_M.gguf

旧版补全端点

Open WebUI 不需要此设置,但更多信息可在原始指南中找到。

env:

useLegacyCompletionsEndpoint: false

APIBase

这是关键一步:您需要将 continue.dev 扩展请求指向您的 Open WebUI 实例。如果实例托管在某个地方,请使用实际的域名(例如 https://example.com/api);如果是本地主机设置,请使用本地地址(例如 https://:3000/api)。您可以在API 端点指南中找到有关 URL 的更多信息。

apiBase: http://:3000/api

API 密钥

要通过您的 Open WebUI 实例进行身份验证,您需要生成一个 API 密钥。请按照本指南中的说明创建它。

apiKey: YOUR_OPEN_WEBUI_API_KEY

角色

这些角色将允许您的模型被扩展用于特定任务。开始时,您可以选择 chat 和 edit。您可以在官方角色指南中找到有关角色的更多信息。

roles:

- chat

- edit

设置现已完成,您可以通过聊天输入与您的模型进行交互。有关 continue.dev 插件的功能和用法的更多信息,请查阅官方文档。